«Переводы»: Эссе Люсиано Флориди. «Стоит ли нам бояться искусственного интеллекта?»

Механизмы похоже становятся все умнее и умнее, да и гораздо лучше справляются с человеческой работой, и тем не менее, появление настоящего ИИ все еще маловероятно. Почему? Concepture публикует перевод эссе Люсиано Флориди.

Люсиано Флориди – профессор философии и информационной этики в Оксфордском университете,

Главный научный сотрудник Центра практической этики Уэхиро.

Его последняя книга «Четвертая революция: Как инфосфера видоизменяет человеческую реальность» (2014).

Представьте себе, что вы вошли в темную комнату в незнакомом вам здании. Вы можете запаниковать, испугавшись монстров скрывающихся в темноте. Или вы можете просто включить свет, чтобы не наткнуться на мебель. Эта темная комната и есть будущее искусственного интеллекта (ИИ). К сожалению, многие люди считают, что как только мы переступим порог, то столкнемся с какими-то злыми, сверхинтеллектуальными машинами. Это представление уходит корнями в 60-е годы 20 века. В тот период Ирвинг Джон Гуд, Британский математик, работавший криптографом в Блетчли-парк вместе с Аланом Тьюрингом, сделал следующее наблюдение:

Допустим, сверхинтеллектуальная машина - это такая машина, которая может значительно превзойти любого человека по всем параметрам, каким бы умным тот не был. Так как создание машин является одним из видов интеллектуальной деятельности, сверхинтеллект может создавать еще более совершенные машины, что непременно приведет к «интеллектуальному взрыву», и человек с его разумом останется далеко позади. Таким образом, искусственный сверхинтеллект является последним из изобретений, которое человечеству когда-либо следует создать, и только при том условии, что машина будет достаточно управляемой для того, чтобы рассказать нам, как себя контролировать. Любопытно, что эти выводы редко делаются вне научно-фантастических книг. Все таки иногда стоит воспринимать научную фантастику всерьез.

Как только искусственный сверхинтеллект станет реальностью, он сможет не просто не быть послушным, а вести себя как «Терминатор»: поработить человечество как подвид, игнорировать его права, и преследовать свои собственные цели вне зависимости от того, какие последствия – это будет иметь для существования человеческого рода.

Если это кажется вам невероятным. То сейчас, возможно, вы захотите переосмыслить свою позицию. Отмотаем-ка время на полвека вперед, в настоящее, где удивительные достижения в области цифровых технологий заставили многих людей поверить в то, что «интеллектуальный взрыв» Джона Гуда действительно может произойти и видовой геноцид со стороны сверхинтеллекта более чем реален, если мы не будем осторожны. Вот слова Стивена Хокинга, сказанные им в 2014 году:

Развитие полноценного ИИ может означать конец человеческой расы.

В прошлом году, Билл Гейтс был того же мнения:

Я вместе с теми, кто обеспокоен проблемой сверхинтеллекта. Сначала, машины станут делать за нас механическую работу. И это, безусловно, будет приносить пользу, если все правильно организовать. Но через несколько десятилетий, их интеллект разовьется достаточно, чтобы стать проблемой. Я согласен с Илоном Маском и остальными, и не понимаю, почему большинство люди так спокойны.

И что же сказал Генеральный директор Тесла, Маск:

Мы должны быть очень осторожны с искусственным интеллектом. Если бы мне предложили назвать самую большую угрозу нашему существованию, пожалуй, это ИИ… Все чаще ученые считают, что возможно должен быть какой-то орган надзора на национальном и международном уровне, чтобы мы не натворили дел. Исследования в области ИИ подобны мистическим ритуалам по вызову демона. Во всех этих историях, где парень с пентаграммой и святой водой искренне уверен, что он сможет контролировать демона обычно ситуация выходит из под контроля.

Реальность же куда более тривиальна. В марте этого года, Микрософт представила TAY– ИИ чат робота для Твиттера. Всего лишь через 16 часов им пришлось удалить его. По мере взаимодействия с живыми людьми, он должен был стать гораздо умнее. Вместо этог, TAY очень быстро стал злобным, обожающим Гитлера, отрицающим Холокост, поощряющим инцест, вопящим «Буш стоит за 9/11» болтуном. Как же так вышло? Произошло это потому, что алгоритм обучения TAY устроен почти как бумажное полотенце. Программа развивалась и оттачивала навыки коммуникации зачастую основываясь на тех отвратительных сообщениях, которые ей присылались, впитывая всю грязь без разбора. В итоге Компания Микрософт извинилась.

И это состояние ИИ на сегодня. После всех этих разговоров об угрозе сверхинтеллектуальных машин, настало время включить свет, перестать беспокоиться о научно-фантастических сценариях и начать фокусироваться на реальных проблемах, чтобы избежать болезненных и дорогостоящих ошибок при разработке.

Давайте будем более конкретными. Философия не слишком хороша в нюансах. Она склонна к созданию точных моделей с остро отточенными различиями, но ее истинная любовь – это противопоставления и дихотомии. Интернализм или экстернализм, фундаментализм или когерентизм, тележка влево или тележка вправо, зомби или не зомби, в зависимости от наблюдателя или независимо от него, возможные или невозможные миры, обоснованное или безосновательное ... Философия может превозносить vel (и девочки и мальчики могут играть), но слишком часто позволяет себе aut aut (либо вам это нравится, либо нет).

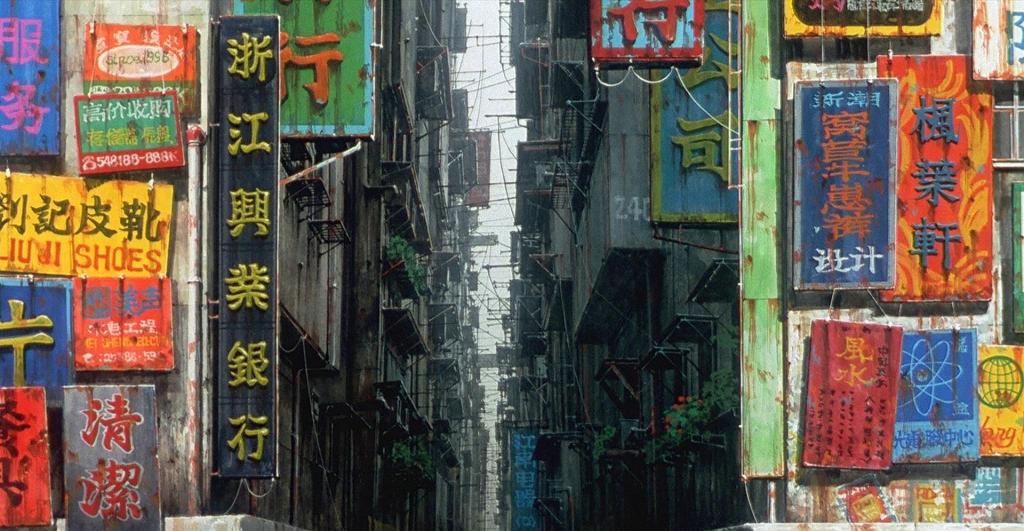

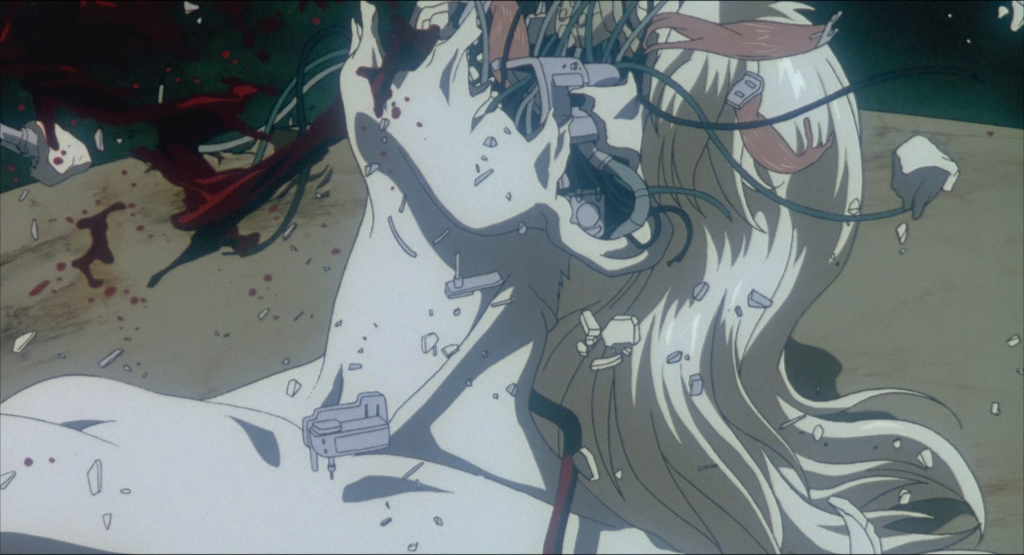

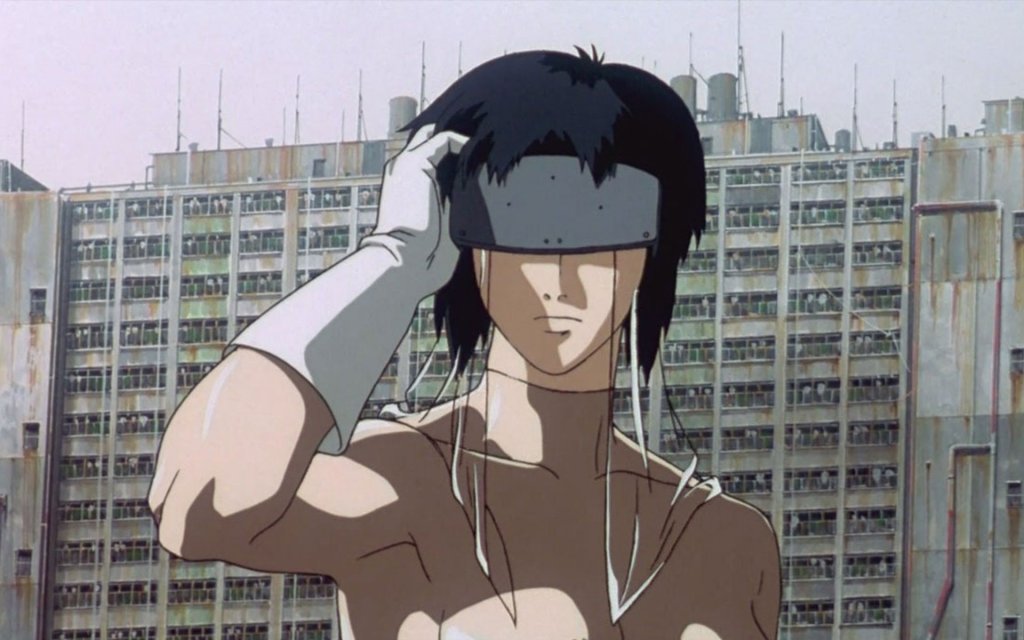

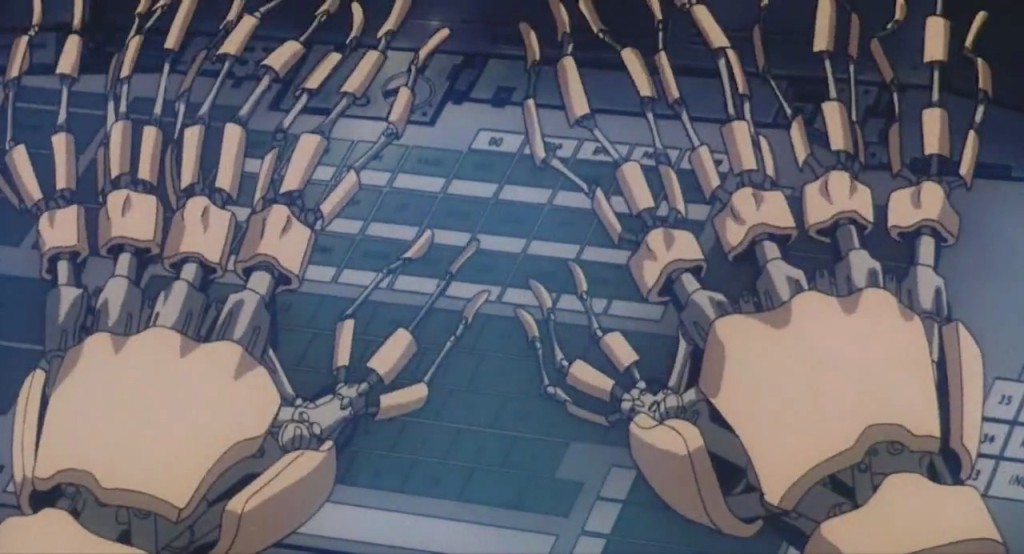

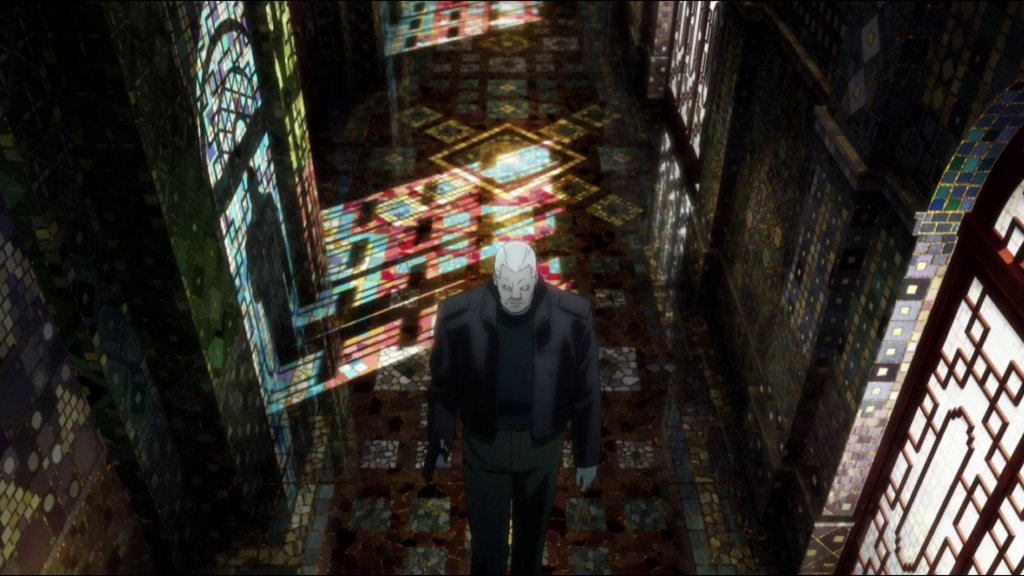

В настоящее время разговоры об ИИ являются показательным примером такого положения вещей. Основные противоречия возникают между теми, кто верит в настоящий ИИ и теми, кто не верит. Да, в реальную вещь, а не Siri в вашем iPhone, Roomba в вашей гостиной, или Nest на вашей кухне (я счастливый обладатель всех трех). Подумайте лучше о ложной Марии в Метрополисе (1927); Hal 9000 в 2001: Космическая Одиссея (1968) (при создании которого Гуд был одним из консультантов); C3PO в Звездных Войнах (1977); Рэйчел в Бегущем по лезвию (1982); Дэйта в Звёздный путь: Следующее поколение (1987); Агенте Смите в Матрице (1999) или бесплотной Саманте в Она (2013). Ну вы поняли. Верующие в истинный ИИ и в Гудовский «интеллектуальный взрыв» принадлежат к «Церкви Сингулярианцев». За отсутствием лучшего термина, я буду обращаться к неверующим как к членам «Церкви ИИтеистов».

Давайте рассмотрим обе принципиальные позиции и увидим, что обе они ошибочны. Важно помнить: хорошая философия почти всегда кроется в скучной середине.

Сингулярианцы верят в три «догмата» (постулата). Во-первых, создание искусственного сверхинтеллекта в той или иной форме, скорее всего случится в обозримом будущем. Этот поворотный момент известен как технологическая сингулярность, отсюда и название «церкви». Природа такого сверхинтеллекта, и сроки его «пришествия» остаются неопределенными, хотя Сингулярианцы, как правило, предпочитают называть будущее «достаточно-близкое-для-беспокойства, но достаточно-далекое-чтобы-доказать-его-невозможность».

Во-вторых, человечество может оказаться порабощенным таким интеллектом.

В-третьих, основной обязанностью нынешнего поколения является предотвращение Сингулярности, либо же, если она все же случится, преобразование ее в нечто благоприятное и приносящее пользу человечеству. Все это элементы манихейства: Робин (читать Джон Ирвирнг) Гуд сражающийся со Злом, апокалиптические обертоны, необходимость «делать что-либо сейчас, иначе будет слишком поздно», эсхатологическая перспектива спасения человечества, и обращение к страху и невежеству.

Поместим все это в контекст, в котором люди «справедливо» обеспокоены воздействием «отупляющих» цифровых технологий на их жизнь, особенно на рынок труда, а средства массовой информации ежедневно сообщают о новых прибамбасах и беспрецедентных бедствиях, случившихся по вине компьютеров, и вы получите рецепт для массового одурманивания: эдакий цифровой опиум для народа.

Как и все религии, основанные на вере, Сингулярианизм неопровержим, потому что, в конце концов, ему не нужны причино следственные связи. Он невозможен еще и потому, что нет никаких оснований полагать, что нечто похожее на интеллектуальную (не говоря уже об сверхинтеллектуальной) машину получится при текущем уровне понимания информатики и цифровых технологий.

Позвольте мне объяснить. Иногда Сингулярианство весьма последовательно. Это умно, потому что тогда действительно следует из если, а не только из ложного - что угодно ex falso quodlibet: если какой-то сверхинтеллект должен был появиться, тогда у нас были бы серьезные проблемы (а не просто «может», как было сказано выше Хокингом).Что ж очень даже логично. Но это также справедливо и для следующего утверждения: если Четыре Всадника Апокалипсиса должны были появиться, тогда у нас были бы еще большие проблемы.

В других случаях, Сингулярианство полагается на маловероятные вещи: какая-то форма искусственного сверхинтеллекта ведь может развиться, не так ли? Да, это может случиться. Но это «может» просто логическая возможность, а насколько нам известно, нет ничего обязательного, в возможности. Тем не менее, этот прием, размывает границу между «я могу быть болен завтра, когда я уже чувствую себя плохо» и «я мог бы быть бабочкой, которой сниться, что она человек».

Как какой-то суперумный ИИ когда-либо начнет автономно эволюционировать из вычислительных навыков, необходимых для парковки в узком месте, остается неясным

Нет никакого противоречия в предположении, что умерший родственник, о котором вы никогда не слышали оставил вам $10 миллионов. Это может случиться. Ну и что? Такая констелляция, как «счастливо женатые холостяки» не может быть основанием для истинной пропозиции, а такая констелляция, как инопланетные агенты, живущие среди нас, так хорошо спрятавшиеся, что мы никогда не обнаружим их, может быть отклонена как совершенно сумасшедшая. Другими словами, утверждение «может» не является утверждением «может случиться» как в случае с землетрясением, но является утверждением «это не правда, что это не может случиться». Как в случае с раздумьями о том, что вы первый бессмертный человек, конечно это вероятно, но не повод, действовать так, будто вы будете жить вечно. Пока не найдется кто-то, кто свидетельствует об обратном, и показывает, что есть что-то в нашем текущем и в обозримом будущем понимания информатики, что должно привести нас к подозрению, что появление искусственного сверхинтеллекта действительно вероятно.

И тут Сингулярианцы смешивают веру и факты, часто движимые, искренним чувством скорого апокалипсиса. Они начинают говорить о потере рабочих мест, о цифровых системах, подверженных риску, о беспилотных самолетах, пошедших наперекосяк и других реальных и тревожных вопросах о вычислительных технологиях, которые приходят, чтобы господствовать в человеческой жизни, от образования до работы, от развлечений до конфликтов. После, они переключаются, на серьезную обеспокоенность в том, что будут неспособны контролировать свою следующую Honda Civic, потому что она будет иметь свой собственный разум. Как вообще супер умный ИИ может получиться из машины с вычислительными навыками, которых едва хватает для парковки в узком месте, остается неясным. Правда состоит в том, что восхождение на вершину дерева не маленький шаг в сторону Луны; это конец пути. То, что мы увидим – все более и более умные машины способные выполнять больше задач, которые мы в настоящее время выполняем сами.

Если все остальные аргументы терпят неудачу, Сингулярианцы любят подключать математику. Закон Мура их излюбленная отсылка. Это статистический закон, в соответствии с которым, в разработке цифровых вычислительных машин, количество транзисторов на интегральных схемах удваивается примерно каждые два года. Результатом являются большие вычислительной мощности за меньшие деньги. Но все течет, все меняется. Технические трудности в области нанотехнологий представляют серьезные проблемы для производства. Существует, в конце концов, предел тому, насколько можно уменьшить что-либо, прежде чем оно просто исчезнет. Закон Мура уже не имеет смысла, если нечто растет в геометрической прогрессии в течение некоторого времени, не означает, что оно будет продолжать делать это вечно, как и утверждил журнал The Economist в 2014 году:

На протяжении всей истории человечества, люди правили безраздельно, как доминирующий вид. Может ли это в ближайшее время измениться? Индюки, до этого безобидные существа, разнеслись в размерах, раздувшись от среднего веса в 13.2lb (6кг) в 1929 году до более чем 30lb (13кг) сегодня. На твердом как скала научном предположении, что нынешние тенденции сохранятся, The Economist подсчитали, что индюки будут размером с людей всего за 150 лет. В течение 6000 лет, индюки займут всю планету. Ученые утверждают, что быстрый рост индеек является результатом инноваций в птицеводстве, таких как селекционное разведения и искусственное оплодотворение. Искусственный характер их роста, а также тот факт, что большинство из них потеряли способность летать, позволяют предположить, что не все потеряно. Тем не менее, с почти 250 миллионами индеек только в Америке, есть повод для беспокойства. В этот День благодарения, есть только один благоразумный курс действий: съесть их, прежде чем они съедят тебя.

От Индюкозавра к ИИзилле, один шаг, если бы не тот факт, что кривая роста легко может быть сигмовидной, с начальной стадией роста, которая практически экспоненциальна, последующей сатурацией, более медленным ростом, зрелостью и, наконец, отсутствием дальнейшего роста. Но я подозреваю, что представление о сигмовидных кривых может оказаться для Сингулярианцев богохульством.

Сингулярианство сбивает с толку. Это болезнь богатого мира, чаще всего беспокоящая людей в праздных обществах, которые, кажется, забывают о реальных бедствиях, угнетающих человечество и нашу планету. Достаточно будет одного примера: почти 700 миллионов человек не имеют доступа к безопасной питьевой воде. Это представляет собой серьезную угрозу для человечества. Да, и на всякий случай, если вы думали, что прогнозы экспертов были надежным проводником, подумайте дважды. Есть много ошеломляюще неправильных технологических прогнозов, сделанных экспертами (см некоторые уморительно веселые от Дэвида Пога и на Cracked.com). В 2004 году Гейтс заявил: «Через два года, проблема спама будет решена». А в 2011 году Хокинг заявил, что « философия мертва »(так что это вы тут читаете?).

Мое самое любимое предсказание сделано Робертом Меткалфом, соизобретателем Ethernet и основателем корпорации производителя цифровой электроники 3Com. В 1995 году он обещал «подавиться собственными словами», если докажут обратное тому, что «Интернет скоро разгорится сверхновой и в 1996 году катастрофически взорвется». Человек своего слова, в 1997 году он публично измельчил свою статью в комбайне и выпил ее. Остается только мечтать, чтобы Сингулярианцы были столь же смелыми и последовательными, как он.

ИИтеисты, глубоко раздраженные неисполнимыми пророчествами тех, кто поклоняется ложным цифровым богам - сделали своей миссией, доказать раз и навсегда, что любой вид веры в истинный ИИ совершенно неправилен. ИИ только компьютеры, компьютеры просто машины Тьюринга, машины Тьюринга являются лишь синтаксическими двигателями, а синтаксические двигатели не могут думать, не могут знать, не могут быть сознательным. Конец истории.

Вот почему существует так много того, что компьютеры (все еще) не могут делать, навскидку название нескольких публикаций – Ира Уилсон (1970); Хьюберт Дрейфус (1972; 1979); Дрейфус (1992); Давид Харель (2000); Джон Сирл (2014) – хотя, что конкретно они не могут сделать весьма удобная в своей гибкости мишень. Они до сих пор не в состоянии обрабатывать семантику (любого языка, включая китайский, независимо от того, чего добивается Google переводчик). Это доказывает, что нет абсолютно ничего, на чей счет стоит беспокоиться. Не существует истинного ИИ, поэтому a fortiori подавно нет никаких проблем, вызванных им. Расслабьтесь и наслаждайтесь всеми этими замечательными электрическими устройствами.

Вера ИИтеистов также неуместна, как и вера Сингулярианцев. Обе церкви имеют много последователей в Калифорнии, где голливудские научно-фантастические фильмы, замечательные научно-исследовательские университеты, такие как Беркли, и некоторые из наиболее важных цифровых компаний мира спокойно процветают бок о бок. Это точно не случайность. Когда в дело вовлечены большие деньги, людей легко запутать. Например, Google скупает компании по разработке ИИ технологий, как если бы не было завтра как будто завтра не наступит (отказ от ответственности: я являюсь членом Консультативного совета компании Google о праве быть забытым), так что, конечно, Google должен знать кое-что о реальных шансах на разработку компьютера, который может думать. Что-то, что мы, вне «Круга» не знаем? Эрик Шмидт, исполнительный директор компании Google, подпитал эту точку зрения, когда он сказал Aspen Institute в 2013 году: «Многие люди считают, что мы близки к разработке [компьютера, который пройдет тест Тьюринга] в течение ближайших пяти лет.

Тест Тьюринга является способом проверки, того настоящий ли перед нами ИИ. Вы задаете вопросы двум агентам в разных комнатах; один из них человек, другой – ИИ; если вы не можете найти разницу между этими двумя базируясь на их ответах, то робот проходит испытание. Это грубый тест. Представьте себе, что это тест на вождение: если Алиса не проходит, она не является безопасным водителем; но даже если она пройдет тест, она все еще может быть небезопасным водителем. Тест Тьюринга обеспечивает необходимое, но недостаточное условие для определения интеллектуальности машины. Это очень низкая планка. И тем не менее, ни один ИИ ни разу не достиг ее. Что еще более важно, все программы продолжают проваливать этот тест таким же образом, используя приемы, разработанные в 1960-х годах. Я даже могу предложить пари. Я ненавижу баклажаны, но, обещаю, съем целую тарелку, если программа пройдет тест Тьюринга и выигрывает золотую медаль премии Лёбнера, прежде чем наступит 16 июля 2018 года. Беспроигрышное пари, правда?

И Сингулярианцы и ИИтеисты ошибаются. Как Тьюринг четко заявил в статье 1950 года, которая представила его тест, на вопрос: «Может ли машина мыслить?» «слишком бессмысленный вопрос, чтобы он заслужил ответ». (Как ни странно, или, возможно, пророчески, но этот же вопрос выгравирован на медали премии Лёбнера) Это справедливо, независимо от того, какой из двух церквей вы принадлежите. Тем не менее, обе Церкви продолжают эту бессмысленную дискуссию, вырезая на корню любой несогласный голос разума.

Истинный ИИ не является логическим противоречием, но он точно не является реальностью. Мы не имеем ни малейшего представления о том, как мы могли бы начать проектировать его, не в последнюю очередь потому, что у нас очень мало понимания того, как наши собственные мозги и интеллект работают. А значит, нам не стоит страдать бессонницей из-за возможного появления ультра-интеллекта. Действительно важно то, что растущее присутствие постоянно развивающихся умнеющих технологий оказывает огромное воздействие на то, как мы понимаем себя, мир, и наши взаимодействия. Дело не в том, что наши машины сознательны, или чересчур умны, или в состоянии что-то понимать и чему-то учиться, как это делаем мы. Они не могут всего этого. Существует множество хорошо известных задач, которые хорошо демонстрируют пределы машинного вычисления, так называемые логические противоречия, при решении которых выясняется, что невозможно построить алгоритм, который всегда приводил бы к единственно верному решению.

Мы знаем, наши вычислительные машины удовлетворяют определению Карри-Говарда, которое гласит, что логические системы доказательства с одной стороны, и модели вычислений с другой стороны, на самом деле структурно идентичны, потому любое логическое ограничение также применимо и к компьютерам. Множество машин умеют делать удивительные вещи, в том числе играть в шашки, шахматы и викторины типа Jeopardy лучше, чем мы. И всё же они лишь версии Машины Тьюринга, абстрактной модели, которая установила пределы возможных машинных вычислений с применением математической логики.

Квантовые компьютеры также ограничены, пределами того, что можно вычислить (так называемые вычислимые функции). Ничего сознательного или разумного не выйдет из машины Тьюринга. Дело в том, что наши интеллектуальные технологии – также благодаря огромному количеству имеющихся данных и некоторых очень сложных программ –в состоянии справляться с большим количеством задач лучше, чем мы, в том числе прогнозировать наше поведение. Таким образом, мы не единственные агенты, способные выполнять задачи успешно.

Это то, что я определил четвертой революцией в нашем само понимании. Мы не в центре Вселенной (Коперника), или биологического царства (Чарльза Дарвина), или рациональности (Зигмунда Фрейда). А после Тьюринга, мы уже и не в центре инфосферы, мира обработки информации и смарт-агентств. Мы разделяем инфосферу с цифровыми технологиями. Это обычные артефакты, которые превосходят нас в еще большем количестве задач, несмотря на то, что они не умней тостера. Их способности унизительны для нас, они заставляют нас переосмыслить человеческую исключительность и нашу особую роль во Вселенной, которая остается уникальной. Мы думали, что мы умны, потому что мы могли играть в шахматы. Теперь телефон играет лучше, чем Гроссмейстер. Мы думали, что мы свободны, потому что мы могли купить все, что мы хотели. Теперь наши модели расходов предсказываются устройством толщиной в дощечку.

Какова же разница? Такая же, как между вами и посудомоечной машиной при мытье посуды. Каковы же следствия? Любым апокалипсическим видением ИИ можно пренебречь

Успех наших технологий во многом зависит от того, что, пока мы рассуждали о возможности ультра-интеллекта, мы постепенно закутали мир покрывалом устройств, датчиков, приложений и данных, он стал раем для технологий, местом где технологии могут заменить нас, не имея при этом зачатков понимания, хоть какой-то ментальности, намерений, способностей к интерпретации, эмоциональных состояний, семантических навыков, сознания, самосознания или гибкого интеллекта. Обычная компьютерная память (как та, что применяется в алгоритмах обработки огромных массивов данных) превосходит человеческий интеллект при посадке самолета, прокладывании самого быстрого маршрута от дома до офиса, или нахождении самой лучшей цены для вашего следующего холодильника.

Цифровые технологии могут сделать лучше, чем мы, при помощи обработки возрастающих объемов данных и повышения эффективности их деятельности. AlphaGo, компьютерная программа, разработанная Google DeepMind, выиграла в Го против лучшего игрока в мире, потому что она могла использовать базу данных около 30 миллионов ходов и играть в тысячи игр против самой себя, «обучаясь», и улучшая свою производительность. Это как система двух ножей, которые могут затачивать сами себя. Какова же разница? А разница такая же, как между вами и посудомоечной машиной при мытье посуды. Каковы же следствия? Любым апокалиптическим видением ИИ можно пренебречь. Мы остаемся и должны оставаться проблемой в обозримом будущем. Мы, а не наши технологии. Так что стоит сосредоточиться на реальных проблемах. В заключение, позвольте мне перечислить пять из них, и все они одинаково важны.

Мы должны сделать ИИ безопасным для окружающей среды. Нам нужны умнейшие технологии, которые мы сможем построить для решения конкретных бедствий, угнетающих человечество и нашу планету, от экологических катастроф до финансовых кризисов, от преступности, терроризма и войн, до голода, бедности, невежества, неравенства и ужасающего уровня жизни.

Мы должны сделать ИИ удобным для человека. Его следует использовать для лечения людей, всегда как последнее средство, никогда как просто лекарство.

Мы должны заставить глупость ИИ работать на человеческий интеллект. Миллионы рабочих мест будут разрушены, устранены и созданы; польза от этого должна быть общей для всех, также как и расходы, которые общество должно поделить.

Мы должны заставить способность ИИ прогнозировать работать на свободу и автономию. Маркетинговые продукты, влияющие на поведение, подталкивающие людей на борьбу с преступностью и терроризмом не должны подрывать человеческое достоинство.

И, наконец, мы должны заставить ИИ сделать нас более человечными. Серьезный риск заключается в том, что мы могли бы неправильно использовать наши интеллектуальные технологии, в ущерб большей части человечества и всей планеты. Уинстон Черчилль сказал, что "мы формируем наши здания, а потом наши здания формируют нас". Это относится и к инфосфере и ее смарт-технологиям.

Сингулярианцы и ИИтеисты будут продолжать свои филиппики о возможности или невозможности появления истинного ИИ. Мы должны быть толерантными. Но мы не должны поддаваться. Вступать? Как Вергилий сказал в аду Данте: «Не говори о них, но посмотри, и пройди мимо них.» Ибо мир нуждается в хорошей философии, а мы должны заботиться о более насущных проблемах.